Fonte:https://outraspalavras.net/tecnologiaemdisputa/chomsky-o-chatgpt-contra-o-pensamento-critico/

Artigo

Chomsky: ChatGPT contra o pensamento crítico

Chomsky: ChatGPT contra o pensamento crítico

Filósofo dispara: novos bots são simuladores poderosos, mas também o oposto da inteligência, do aprendizado e da reflexão. Capital quer empregá-los para nublar o debate público. Porém, saída não é freá-los — e sim estimular a educação política

Publicado 02/05/2023 às 20:04 - Atualizado 03/05/2023 às 18:02

Entrevista a Ivo Neto e Karla Pequenino no Público

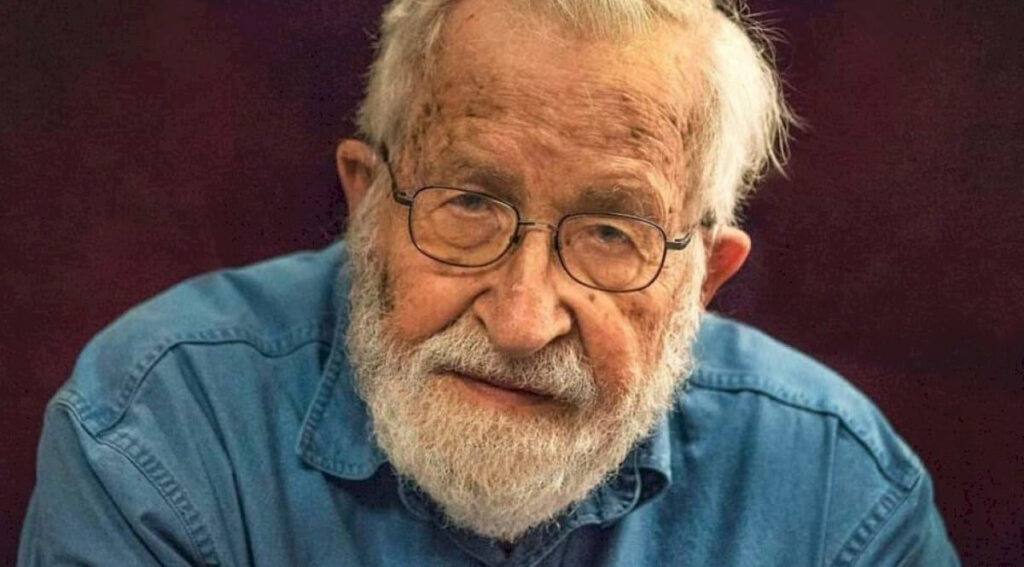

Há um mês, o reputado filósofo e linguista Noam Chomsky co-assinou um artigo no New York Times em que condena a “falsa promessa do ChatGPT”, criticando o rumo que o desenvolvimento da inteligência artificial (IA) levou. Ao Ípsilon, numa videochamada, o especialista do MIT reforçou a preocupação com a forma como a tecnologia está evoluindo, com algoritmos que nos dão conteúdo à nossa medida e chatbots que simulam a comunicação humana e contribuem para a inércia analítica e criativa.

“Este é o ataque mais radical ao pensamento crítico, à inteligência crítica e particularmente à ciência que eu jamais vi”, diz o pensador, com 94 anos, apontando a forma como as ferramentas assumem cada vez mais uma dimensão “corporativa”. “A ideia de que podemos aprender alguma coisa com este tipo de IA é um erro”, atira.

Questionado sobre o que fazer com esta mudança tecnológica, que aconteceu de forma tão brusca/, Chomsky destaca o papel da educação. “É impossível travar os sistemas”, avisa ele, que não assinou a carta em que especialistas de todo o mundo pediram uma moratória no desenvolvimento de IA. Explica por quê: “A única maneira [de controlar a evolução tecnológica] é educar as pessoas para a autodefesa. Levar as pessoas a compreender o que isto é e o que não é.” Atribui um significado político a ferramentas como o ChatGPT: “É basicamente como qualquer outra ideologia ou doutrina. Como é que se defende alguém contra a doutrina neofascista? Educando as pessoas.”

O especialista diz que o cenário atual representa “a longa luta de classes”. “É outro caso em que se tenta subordinar, marginalizar as pessoas, ao levá-las a olhar para o Instagram, ou falar com um chatbot sem pensar no que está acontecendo no mundo”, defende.

Quando você nos confirmou a disponibilidade para esta entrevista, fomos ao ChatGPG, que se tornou uma das ferramentas mais associadas à IA, e perguntamos que questões colocar a Noam Chomsky.

Vamos, então, começar com uma dessas perguntas. Seria possível criar uma inteligência artificial capaz de compreender e utilizar a linguagem humana da mesma forma que os seres humanos o fazem?

Há um campo de estudo que se liga a essas questões: é a ciência cognitiva. A IA não lida com isso, centra-se noutros aspectos.

Atualmente é um dos elementos do movimento anticiência. Preocupa-se, sobretudo, com simulação e não com o entendimento. O ChatGPT é, assim, um exercício inteligente de simulação. Percorre quantidades astronômicas de dados, por meio de programas inteligentes, para produzir resultados semelhantes à informação que encontra. Não diz nada sobre linguagem, aprendizagem, inteligência. E isso é muito fácil de provar.

Como é que se mostra que o ChatGPT é só um simulador?

Estes sistemas, se olharmos para eles, funcionam para linguagens impossíveis. Funcionam com linguagens que as crianças não conseguem aprender, assim como as linguagens existentes. Seria o mesmo que um físico chegasse e dissesse: está aqui um conjunto de possibilidades que podem acontecer e outras que não podem acontecer e não identifico qualquer diferença entre elas. Isto não é ciência.

O que vê então como inteligência artificial?

Se olharmos para o que Alan Turing [1912-1954] disse, há já muito tempo, a IA é descrita como a capacidade para utilizar computadores e programação para ver se conseguimos alguma compreensão sobre o que é a inteligência humana. Isso é ciência pura. Só que a IA, tal como é entendida atualmente, é um projeto corporativo que visa reunir conteúdos para serem usados por sistemas de simulação em grande escala. A ideia de que podemos aprender alguma coisa com este tipo de IA é um erro. Elas [as tecnologias de IA] criam uma atmosfera onde a explicação e a compreensão não têm qualquer valor. O que se faz é tentar simular um ataque profundo à natureza não só da ciência, mas também da investigação racional no seu conjunto.

Como é que os especialistas deveriam tratar as questões relacionadas com a IA?

Não há nada de errado no que estão fazendo, se o interesse for a simulação. Pode ser positivo. Eu uso [programas de inteligência artificial] nas legendas durante as entrevistas porque já tenho dificuldades auditivas. Mas a investigação de IA acontece, por exemplo, nos estudos sobre a forma como os bebês pensam. O livro What Babies Know, de Elizabeth Spelke, inclui uma análise detalhada sobre a forma como os bebês adquirem a linguagem e a compreensão do ambiente que os rodeia durante o primeiro ano de vida. Isto é feito usando experimentação científica e outros métodos, como análises estatísticas dos exemplos disponíveis para as crianças [aprenderem]. Estes métodos de investigação convergem para se descobrir como é que os humanos desenvolveram as capacidades intelectuais. É como estudar uma colônia de formigas para perceber como operam. Para isso, é preciso ciência, não simulação.

O desenvolvimento das plataformas de IA generativa, como o ChatGPT ou o Dall-E, tem suscitado receios devido à desinformação. Há umas semanas, uma imagem, em que o Papa aparecia vestido com roupa diferente da que habitualmente usa, foi partilhada por muitos como se fosse verdadeira. A mente humana está preparada para lidar com o que é falso ou verdadeiro?

Vamos pegar um caso concreto e possível, com o qual estamos bastante familiarizados há centenas de anos: um hábil estudante de Arte vai ao museu e cria uma cópia muito sofisticada do auto-retrato de Rembrandt. É preciso um historiador de arte sofisticado para dizer a diferença entre o original e a cópia. Hoje em dia, os historiadores de arte utilizam a tecnologia para tentar distinguir as cópias das obras originais. E é muito difícil. Essa é a natureza da simulação. Pode ser tão sofisticada que uma pessoa que não esteja tão bem preparada não note a diferença. É o caso da imagem do Papa. Isso abre portas a outras questões.

Como roubo de identidade ou difamação.

Exatamente. Estes novos sistemas são uma ferramenta fantástica para a difamação e serão certamente utilizados para isso. O exemplo [do Papa] que você mencionou é uma espécie de piada e pretendia, certamente, ser uma piada. Mas muito em breve, podem ter a certeza, haverá uma utilização maciça da simulação de vozes, de rostos, de elementos, que, combinados, pretenderão atribuir algo a uma pessoa que, na verdade, não tem responsabilidade nisso. Podem ser criados conteúdos, atribuídos a pessoas críveis, dando credibilidade aos maiores disparates imagináveis.

Mas há outro tipo de riscos. Como as pessoas que olham para estes programas como reais. E fazem perguntas como: devo deixar a minha mulher? As pessoas são extremamente ingênuas. Já há casos [em que foram feitas perguntas como estas] com sistemas como a Alexa ou a Siri… As pessoas desenvolvem relações [com as máquinas] e até podem se apaixonar. Isso é muito perigoso. Há casos de suicídio em que as pessoas seguiram os conselhos dos dispositivos de simulação.

A capacidade de danos é extraordinária. Há algumas semanas, um grande número de especialistas de todo o espectro pediu uma moratória no desenvolvimento desta tecnologia, devido aos enormes danos que podem ser causados.

Há forma de travar o desenvolvimento de uma tecnologia deste tipo?

A desinformação já acontecia com a internet. Há artigos publicados online em que apareço como autor principal e não foram escritos por mim. E depois de chegarem à Internet, é impossível parar a sua propagação. E, depois, há outra pergunta: o que resulta desse esforço tecnológico é tão útil, como acontece com as legendas desta entrevista? Isso não é assim tão óbvio.

Então concorda com as pessoas que assinaram a petição pedindo calma na evolução da tecnologia de IA?

Eu não assinei a petição.

De fato, esperávamos de ver o seu nome lá.

Não assinei por duas razões. Primeiro, porque o texto exagerou muito o que os sistemas estão de fato fazendo e são capazes de fazer – e, portanto, contribui para essas ilusões e mal-entendidos. A outra razão é que é impossível travar os sistemas. Não se pode impedir os atores maliciosos de inundar a Internet com todo o tipo de lixo.

A única maneira de ajudar é educar as pessoas para a autodefesa. Podemos levar as pessoas a compreender o que IA é e o que não é. Acabar com a euforia e olhar para a realidade como ela é. É basicamente como qualquer outra ideologia ou doutrina. Como é que se defende alguém contra a doutrina neofascista? Educando as pessoas. Não há maneira de a impedir, não vai acabar nem desaparecer. Pode-se educar a população para compreender como realmente são as coisas.

E como é que se deve educar? Pode dar exemplos mais concretos?

Tome um demagogo como Trump. é um ator muito hábil. Sabe como apartar os botões certos. Sabe falar para as pessoas com um cartaz numa mão a dizer “te amo” enquanto as apunhala nas costas com a outra.

Não podemos dizer às pessoas: “Olha, ele não te ama”. É preciso dizer: “Olha, estão te apunhalando pelas costas”. Deve-se apontar para o programa legislativo [destes políticos] e mostrar o que realmente é – um serviço abjeto à riqueza privada e ao poder empresarial. Mas a verborreia [de Trump] não fala disso. Pelo contrário, diz que é do partido das pessoas, das pessoas que trabalham. E safa-se. Basta olhar para as pesquisas. Falta educação, e essa educação, essa proteção, era o que se fazia quando se tinham organizações que representavam as pessoas.

Os movimentos sindicais.

Ronald Reagan e Margaret Thatcher, quando inauguraram o assalto neoliberal, tiveram, eles ou os assessores, uma primeira ideia-chave: acabar com os sindicatos. Porque é o meio de defesa que as pessoas têm para se reunir, deliberar e trabalhar em conjunto. Portanto, o primeiro passo das administrações de Reagan e Thatcher foi destruir os sindicatos e abrir a porta para que o setor empresarial avançasse com todo o tipo de meios, na sua maioria ilegais, de trabalho.

Os chamados libertários, como Milton Friedman, odiavam os sindicatos. O próprio Mussolini foi elogiado por ter destruído os sindicatos em Itália porque interferiram com a economia. Este é o cerne da ideologia. Se está à serviço de grandes riquezas ou poder, assegure-se de que não haja oposição.

Acredita que as novas ferramentas de IA também podem contribuir para uma realidade ainda mais polarizada?

Vão certamente ser usadas com esse propósito, basta olharmos para o mundo em que vivemos. Estes movimentos anticiência começaram há várias gerações. A indústria do tabaco, há 70 anos, foi uma das propulsoras, com um amplo programa de desinformação. Quando se descobriu que o tabaco era letal, a indústria do tabaco não se limitou a negar esses fatos: tentou atacar as provas científicas, explicando que a ciência não é definitiva. Mais recentemente, temos a indústria dos combustíveis fósseis. A estratégia é influenciar o público a ponto de negar a objetividade da ciência, ao semear dúvidas, ao dizer que a ciência não é fiável, ao alertar para o desemprego.

Penso que a chamada inteligência artificial enquadra-se muito bem nisso. [As ferramentas de IA] estão induzindo no público uma sensibilidade que nega fundamentalmente o objetivo da ciência. De que vale compreender o que quer que seja quando se pode analisar um sem fim de dados e prever o que vai acontecer? Este é o mais radical ataque ao pensamento crítico, à inteligência crítica e particularmente à ciência que eu alguma vez vi.

A azáfama em torno da IA faz com que as pessoas também comecem a estar dessensibilizadas em relação aos riscos. Como é que se luta contra isto?

Pensemos nos direitos das mulheres. Se perguntassem à minha avó, quando ela estava na cozinha tomando conta da família, “Você está privada dos seus direitos?”, ela não saberia do que estavam falando. As mentalidades começaram a mudar por causa de mulheres jovens em movimentos ativistas que começaram a questionar-se: “Por que é que temos de fazer isso? Por que temos de estar subordinadas? Essas dúvidas propagaram-se e conduziram àquele que é provavelmente o principal movimento da história moderna em termos de consequências e resultados.

Não há forma de parar essas coisas, exceto pela forma como foi feito ao longo da história por pessoas que se organizam e lutam por direitos, conquistando-os ao longo dos anos.

Alguns países começaram a avançar com legislação nesta área. Concorda com este modus operandi?

A proibição não ajuda. Não podemos proibir o Mein Kampf, de Adolf Hitler. O que se tem de fazer é encorajar as pessoas a lê-lo e a descobrir o que é. Quer viver neste tipo de mundo? Isso é o que se faz. Não podemos nos esquecer de uma coisa: há imenso capital investido nestas tecnologias. Há instituições e organizações poderosas que vão se envolver nestas tecnologias e encontrarão inúmeras formas de contornar a legislação. Especialmente se as pessoas realmente quiserem isto [IA], criando uma lógica de procura e oferta. Aí as grandes organizações vão, certamente, encontrar uma foma de contornar a lei.

E há alguma forma de mitigar essa procura? Vivemos numa sociedade inteiramente digital. Já não deve faltar muito tempo para termos os nativos digitais em órgãos de decisão.

A verdadeira forma de controlar o processo é acabar com a procura. Fazer com que as pessoas compreendam que há mais coisas do mundo aleḿ das fantasias na Internet. Há situações cada vez mais preocupantes. Recentemente foi publicado um estudo, aqui nos EUA, sobre a Geração Z, crianças que nasceram depois de 1997, e a forma como encontram informação sobre o mundo. Quase ninguém lê jornais ou vê televisão. Muito poucos vão ao Facebook, porque já é antiquado. Imaginem o que é ter uma geração inteira a criar a sua visão do mundo através do que se vê no TikTok? Estamos falando da possibilidade de perdermos uma geração. E a legislação aqui não vai ter grande poder. Não se pode banir o Instagram ou o TikTok.

Gostaríamos de voltar atrás ao fato de as pessoas confiarem e procurarem respostas em tecnologias de IA, como os chatbots, mesmo não se tratando de humanos, o chamado “efeito Eliza”. Porque é que as pessoas confiam nas máquinas?

Por que uma criança de três anos fala com os seus brinqudos? Há algo nestas tecnologiais que lembra a nossa infância e todos podemos ser apanhados nisso.

A confiança que damos à IA vem de uma necessidade de continuarmos a ter amigos imaginários?

Há uma possibilidade de desenvolvermos o nosso próprio mundo, como se fossemos avatares. Pode ser um ato de criatividade. Outro exemplo é a literatura. Se você passar grande parte do tempo a ler romances, vai conhecer melhor as pessoas desses romances do que as pessoas que realmente conhece. Porque sabe aquilo em que acreditam. Não temos esse tipo de informação sobre os nossos melhores amigos. Não há nada de errado [com a criatividade], é uma das mais importantes conquistas da inteligência do ser humano. Mas se alguém se apaixona verdadeiramente por uma personagem de um romance, isso é um problema.

Esse é um dos problemas da IA? A ideia de que pode nos dar a verdade que queremos?

Pode dar algo tranquilizante, confortável, alguma coisa de que o utilizador gosta e encaminhá-lo para este tipo de mundo. Dar essa ilusão. E isto vai ser utilizado por atores maliciosos.

Se continuarmos a desenvolver estes simuladores, corremos o risco de estar presos em visões distintas do mundo com máquinas que repetem aquilo que queremos ouvir?

É como doutrina e ideologia. Pensemos na Itália: durante o período fascista, as pessoas aceitavam, acreditavam e apoiavam a ideologia fascista. Não vale a pena fingir que não o fizeram. Mussolini era muito popular e, na Alemanha, Hitler era ainda mais popular. As pessoas acreditavam neles e os queriam.

O que se faz, nestes casos, é criar meios de autodefesa. E, como disse, algo que Mussolini, Hitler e também Thatcher compreendiam muito bem é que se tem de destruir a principal forma de as pessoas se defenderem – é preciso eliminar os sindicatos, impedir as pessoas de falarem umas com as outras. É preciso deixá-las separadas. Isto é o mercado ideal. Todos estão sozinhos, a perseguir as suas próprias fantasias, sejam elas quais forem. É o sistema ideal para controlar as pessoas. A longa luta de classes está sempre em curso. O cenário atual, com a tecnologia e a IA, é outro caso em que se tenta subordinar, marginalizar as pessoas, ao levá-las a olhar para o Instagram ou a falar com um chatbot sem pensar no que está a acontecer no mundo.

Já vimos alguns comentaristas e políticos de direita dizer que a IA generativa é enviesada e privilegia opiniões de esquerda e que precisam de criar a “sua” versão das ferramentas. É o começo de um novo tipo de guerra cultural?

Bom, a direita adora falar sobre como é vitimizada. São donos de tudo, gerem tudo, mas argumentam que são vítimas. Lembra a teoria da Grande Substituição. É a ideia de que a raça branca, que tem todas as vantagens, é a vítima porque sente que está sendo substituída. Que o dono dos escravos é a vítima se o escravo não consegue fazer o seu trabalho. E, provavelmente, o dono dos escravos acredita mesmo nisso.

Muitos economistas dizem que não vai demorar muito tempo para que estas máquinas substituam os trabalhadores humanos em algumas atividades.

Atualmente há uma grande preocupação quanto a escritores, arquitetos e engenheiros perderem os seus empregos. Isso é bastante interessante. A classe operária vem perdendo postos de trabalho há muito tempo devido à automação. Quem se preocupa com isso? Mas se os empregos de colarinho branco, detidos por homens, estiverem em risco, então é uma catástrofe… Desde o século XVII que a automatização eliminou empregos, com o fim dos tecelões na Índia.

Acredita que as máquinas vão mesmo substituir as pessoas no trabalho?

Não creio que seja provável que muitas dessas pessoas percam o emprego. Mas, se o fizerem, bem, isso tem sido o curso da história durante muito tempo. Agora está atingindo algumas pessoas privilegiadas, em vez das vítimas habituais.

E será que as grandes empresas tecnológicas, como o Google e a Meta, terão mais poder político porque estão por trás da tecnologia que as pessoas começam a precisar de usar?

As grandes empresas têm poder político por uma razão muito simples: dinheiro, capital. Podem comprar congressistas, podem comprar senadores, podem comprar eleições. Chama-se a isso poder. Não é nada de novo.

Suponha que você seja eleito para o Congresso nos Estados Unidos. A primeira coisa que fará é telefonar aos financiadores para se certificar de que eles o ajudarão nas próximas eleições. Quando o congressista desliga o telefonema, vai ao seu escritório e assina a nova legislação sobre aquilo que precisam. Estou fazendo uma caricatura, mas é basicamente assim que o sistema legislativo funciona. Com isto, cerca de 70% da população dos Estados Unidos não é representada. Não há uma correlação entre as suas atitudes e preferências e a legislação que é aprovada pelo seu representante no Congresso. Ou seja, eles não são representados. São os poderosos que escrevem a legislação. Isto é um problema que existe nas sociedades capitalistas.